模型部署的艺术:让深度学习模型跃入生产现实

1 引言

1.1 部署的意义:为何部署是项目成功的关键

在深度学习项目的生命周期中,模型的部署是其成败的关键之一。通常,一个模型从概念构思、数据收集、训练到优化,最终目的是为了解决实际问题,提高业务效率或创造新的价值。因此,如果一个模型无法被有效部署到生产环境中,那么无论它的准确率有多高,速度有多快,都只能是沦为实验室里的玩具。部署不仅仅是将一个模型置于在线环境中,更关乎于如何让模型在实际环境下稳定、高效地运行,以及如何进行监控和维护以应对未来可能出现的各种情况。

例如,一个为自动驾驶车辆设计的物体识别模型,只有在被部署到车辆的计算系统中,并在实际道路环境下准确、快速地识别出各种物体,才能说是成功的。这涉及到了模型的压缩、优化、硬件选择、性能监控等一系列复杂的过程。

1.2 故事框架:从实验到用户手中的旅程

将一个深度学习模型从实验室带到最终用户手中的过程,可以看作是一次长途旅行。旅途开始于模型的训练,这是为旅行准备必需的知识和能力。随后,模型需要经过多轮的打包与优化,就像打包行李一样,既不能带得太多以至于负担沉重,也不能遗漏关键物品。接着,选择合适的部署环境,就如同选择旅行的目的地,可能是云环境,也可能是边缘设备。在这个过程中,模型会经历各种测试和优化,以确保它能够高效运行,并能够适应环境的变化。

接下来,模型被部署到选定的环境中,开始在真实世界中工作。但旅程并未结束,监控模型的表现,定期检查和维护,保证其长期稳定运行,就像旅途中的不断调整和改进。最终,模型能够在真实环境中稳定运行,为用户提供价值,这次旅行才算是真正成功。

在整个旅程中,需要深入理解和运用多个技术和方法。例如,模型压缩可以通过知识蒸馏(Knowledge Distillation)实现,即通过让一个小型的网络(学生)学习一个大型网络(教师)的输出,来保持模型的性能同时减少其体积。具体地,假设教师模型的输出为 p p p,学生模型的输出为 q q q,那么知识蒸馏的目标函数可以表示为:

L = H ( q , p ) + α ⋅ H ( q , y ) L = H(q, p) + \alpha \cdot H(q, y) L=H(q,p)+α⋅H(q,y)

其中, H H H 是交叉熵, y y y 是真实标签, α \alpha α 是一个权重参数,用于平衡两个目标。通过这个过程,可以有效地将大型模型的知识转移到小型模型,使得小型模型在保持较小体积的同时,也能达到接近大型模型的表现。

2 模型的打包与优化

在深度学习的生命周期中,模型的打包与优化是实现其商业价值的关键步骤。这不仅仅是技术上的挑战,而是一种艺术,需要在模型性能和资源消耗之间寻找最佳平衡点。本章节旨在深入探讨模型压缩与转换的各种策略以及实际示例,帮助开发者有效地进行模型的打包与优化。

2.1 模型压缩:减少体积,提升效率

模型压缩是一种减少深度学习模型体积的技术,目的是降低模型在存储和计算上的需求,而尽量保持其性能。压缩方法通常包括权重剪枝、量化、知识蒸馏等。

-

权重剪枝通过移除模型中不重要的权重来减少模型大小。数学上,假设我们有一个权重矩阵 W W W,剪枝就是通过一个掩码矩阵 M M M与 W W W进行元素乘法操作,即 W ′ = M ⊙ W W' = M \odot W W′=M⊙W,其中 M M M中的元素是0或1,决定了对应的权重是否被保留。

-

量化指的是将权重从浮点数转换为低比特数的整型表示。例如,8-bit量化会将权值从32-bit的浮点数转换为8-bit的整数。这种转换可以用公式 W q = r o u n d ( W s c a l e ) W_q = round(\frac{W}{scale}) Wq=round(scaleW)表示,其中 s c a l e scale scale是根据权重分布确定的缩放因子。

-

知识蒸馏则是一种训练技术,其中一个小的“学生”模型试图模仿一个大的“老师”模型的行为。这通常涉及到最小化学生模型输出和老师模型输出的差异。如果我们将老师模型的输出表示为 T T T,学生模型的输出表示为 S S S,那么知识蒸馏的目标可以通过交叉熵损失 H ( T , S ) H(T, S) H(T,S)来表示。

2.2 必要的转换:TF Lite和ONNX

部署模型时,通常需要将模型转换为更加适合特定平台的格式。TensorFlow Lite和Open Neural Network Exchange (ONNX)是两种流行的模型格式,分别适用于移动设备和跨平台部署。

-

TF Lite是为移动和嵌入式设备设计的,可以将原有TensorFlow模型转换为优化后的FlatBuffer格式,极大地缩小模型大小并提升运行速度。转换的过程可以用以下公式概述:设定转换器参数 C C C,原模型 M M M经过转换器 f ( C , M ) f(C, M) f(C,M)后得到TF Lite模型 M t f l i t e M_{tflite} Mtflite。

-

ONNX提供了一个开放的生态系统,可以使模型在不同的框架和工具之间实现互操作性。例如,将PyTorch模型转换为ONNX模型,涉及到的计算可以用 M o n n x = g ( M ) M_{onnx} = g(M) Monnx=g(M)描述,其中 g g g是从PyTorch到ONNX的转换函数。

2.3 注释:模型转换示例代码

在实践中,模型转换通常涉及一系列详细的步骤,包括模型的加载、转换器参数的设置、以及实际的转换过程。例如,将TensorFlow模型转换为TF Lite模型的过程可以通过以下Python代码片段进行说明:

import tensorflow as tf

# 加载已经训练好的TensorFlow模型

model = tf.keras.models.load_model('my_model.h5')

# 设置TF Lite转换器参数

converter = tf.lite.TFLiteConverter.from_keras_model(model)

# 启用优化

converter.optimizations = [tf.lite.Optimize.DEFAULT]

# 执行模型转换

tflite_model = converter.convert()

# 将转换后的模型保存为.tflite文件

with open('model.tflite', 'wb') as f:

f.write(tflite_model)

在这个例子中,我们首先加载了一个Keras模型,然后创建了一个转换器对象,并对其进行了一定的设置,比如启用默认优化。最后,我们调用convert方法完成转换,并将结果保存到文件中。

模型的压缩与优化是将深度学习模型从研究室带向实际应用的必经之路,每一步都需要精心设计以确保模型的性能不会受到太大影响。通过上述技术,开发者可以有效地减小模型大小,提升运行效率,最终实现在多样化的环境中快速部署和运行深度学习模型。

3 选择部署环境

在深入探讨如何选择合适的部署环境之前,我们必须清楚认识到,深度学习模型的部署并非是将训练好的模型放置在某个服务器上那么简单。它是一个涉及资源管理、延迟优化、成本控制等多方面综合考量的决策过程。接下来,我将引导大家了解如何根据项目需求、成本预算和性能要求来选择最合适的部署环境。

3.1 云服务:各大云服务商比较

现今,市场上有多家云服务提供商,例如Amazon Web Services (AWS), Google Cloud Platform (GCP), Microsoft Azure等。每一家都有它们的优势与劣势。选择云服务最重要的是考虑它们的计算能力、存储选项、网络技术、以及价格。

比如,AWS的Elastic Compute Cloud (EC2) 提供多种实例类型,适用于不同的工作负载和预算。对于深度学习应用,我们可能会倾向于选择配备GPU或TPU的实例类型来加速模型的推理过程。例如,对于需要高性能计算的任务,我们可能会选择p3或p4实例,这些实例配备了NVIDIA Tesla V100和A100 GPUs,它们能够提供高达1 PetaFLOPS的混合精度性能。

在选择云服务商时,我们还需要考虑以下方程式,以确保成本效益:

Cost-Effectiveness = Performance Cost \text{Cost-Effectiveness} = \frac{\text{Performance}}{\text{Cost}} Cost-Effectiveness=CostPerformance

举例来说,如果我们的模型每天处理数百万次推理,而且对延迟敏感,那么选择具有高计算能力但略微昂贵的实例可能比选择低成本但计算能力较弱的实例更为合适。

3.2 边缘计算:何时何地使用边缘计算

边缘计算指的是将数据处理和分析的过程尽可能地靠近数据源头,这通常意味着在物理上离用户或数据产生点较近的位置。对于深度学习部署来说,边缘计算可以带来几个关键的优势,包括但不限于降低延迟、减少带宽使用和提高隐私保护。

考虑一个自动驾驶汽车的例子,在这种场景下,每一毫秒的延迟都可能影响决策的准确性,因此在车辆上部署模型(即边缘计算环境)可以实现实时处理,而无需等待数据被发送到远程服务器并返回。这里,时延通常可以用以下公式来估计:

Latency = Data Size Bandwidth + Processing Time \text{Latency} = \frac{\text{Data Size}}{\text{Bandwidth}} + \text{Processing Time} Latency=BandwidthData Size+Processing Time

在这个方程中,通过将数据处理近源完成,我们可以显著降低时延。

3.3 注释:选择部署环境的决策树

选择部署环境可以使用以下决策树来辅助:

- 评估应用程序对延迟的敏感度。如果应用需要实时或近实时响应,优先考虑边缘计算。

- 分析数据处理的地点。如果数据隐私是一个问题,或者数据的传输成本高昂,再次考虑边缘计算。

- 估算预算。如果预算有限,云服务商可能提供更多的灵活性和成本效益。

- 考虑可伸缩性需求。如果应用预期有波动性高或难以预测的负载,云服务的自动扩展机制可能是一个重要因素。

在本文中,我们讨论了如何根据不同的需求和条件选择部署环境。这个决策将直接影响到模型部署后的性能和成本,因此必须仔细分析。无论是选择云服务还是边缘计算,核心目标都是确保我们的深度学习模型可以高效、稳定地服务于最终用户。在后续章节中,我们将进一步探讨模型在云端和边缘设备上的具体部署策略和最佳实践。

4 模型在云端的部署实战

在深度学习项目的生命周期中,将模型从实验室带到实际生产环境是一个临门一脚的步骤。这不仅需要技术的转变,更需要战略和流程上的精细打磨。在这一章节中,我们将深入探讨如何在云端实施模型的部署,确保其高效、可扩展且可靠地服务于最终用户。我们将通过容器化技术,如Docker和Kubernetes,讲述自动化部署流程,并使用可视化工具来展示云部署的全过程。

4.1 容器化:Docker与Kubernetes简介

容器化可以被理解为一种轻量级、可移植的软件分发方式。Docker,作为最流行的容器平台,允许我们将应用和环境打包成一个独立的容器,这个容器在任何支持Docker的机器上都能运行。而Kubernetes是一个开源的容器编排工具,它管理应用程序的生命周期,包括部署、扩展和更新。

为了实现模型部署,我们首先需要创建一个Dockerfile:

# 使用轻量级的Python镜像

FROM python:3.8-slim

# 设置工作目录

WORKDIR /app

# 安装依赖

COPY requirements.txt /app/

RUN pip install --no-cache-dir -r requirements.txt

# 将代码复制到容器中

COPY . /app/

# 设置环境变量

ENV MODEL_PATH=/app/models/my_model.h5

# 运行API服务器

CMD ["python", "app.py"]

使用Kubernetes,我们可以定义一个部署配置文件deployment.yaml来规定如何运行和扩展我们的应用:

apiVersion: apps/v1

kind: Deployment

metadata:

name: deep-learning-model

spec:

replicas: 3

selector:

matchLabels:

app: dl-model

template:

metadata:

labels:

app: dl-model

spec:

containers:

- name: dl-model-container

image: my-dockerhub-username/my-model-image

ports:

- containerPort: 80

这里定义了一个名为deep-learning-model的部署,它将确保我们有三个模型的副本在运行,以提供高可用性。

4.2 自动化部署:CI/CD管道

持续集成(CI)和持续部署(CD)是现代软件开发过程中不可或缺的一部分。通过自动化管道,我们能够保证代码的每一次提交都会被测试、构建,并且部署到生产环境中,这减少了人为错误的可能性,提高了软件交付的速度。

一个简单的CI/CD管道可以通过GitHub Actions来实现:

name: Model CI/CD Pipeline

on:

push:

branches: [ main ]

jobs:

build-and-push:

runs-on: ubuntu-latest

steps:

- uses: actions/checkout@v2

- name: Set up Python

uses: actions/setup-python@v2

with:

python-version: '3.8'

- name: Install dependencies

run: pip install -r requirements.txt

- name: Build and push Docker image

uses: docker/build-push-action@v2

with:

push: true

tags: my-dockerhub-username/my-model-image:latest

这个流程会在每次向main分支提交代码时触发,构建Docker镜像,并将其推送到Docker Hub。

4.3 可视化图表:云部署流程图

对于复杂的系统,可视化流程图是沟通和理解系统架构的关键工具。一个典型的云部署流程可能包括以下步骤:

- 开发人员提交代码到版本控制系统(如Git)。

- CI/CD管道自动运行,执行测试,构建容器镜像。

- 镜像被推送到容器注册中心(如Docker Hub)。

- Kubernetes集群根据部署配置拉取最新的镜像,并更新服务。

我们可以使用软件如Lucidchart或Draw.io来创建这样的流程图,为团队成员提供直观的架构理解。

4.4 注释:云端部署脚本示例

当然,为了实现云端的部署,我们通常需要编写脚本来自动化整个过程。以下是一个使用kubectl与Kubernetes集群交互的脚本示例:

#!/bin/bash

# 设置Kubernetes集群凭据

KUBE_CONFIG_PATH=~/.kube/config

# 应用Kubernetes部署配置

kubectl --kubeconfig=$KUBE_CONFIG_PATH apply -f deployment.yaml

# 更新服务以使用新的Docker镜像

kubectl --kubeconfig=$KUBE_CONFIG_PATH rollout restart deployment/deep-learning-model

在这一章节中,我们已经探讨了如何在云端部署深度学习模型的基础知识和实战步骤。通过容器化技术,自动化部署流程,以及可视化工具,我们能够高效和可靠地将模型服务于最终用户。

5 模型在边缘设备上的部署实战

5.1 硬件选择:设备能力评估

选择正确的硬件是在边缘设备上部署深度学习模型的第一步。这不仅涉及了对计算能力、内存大小和电能消耗的权衡,还需要考虑设备的物理尺寸和成本。例如,NVIDIA Jetson系列提供了多种适合边缘计算的GPU加速器,它们在保持相对低能耗的同时,提供了强大的深度学习性能。

设备选择的一般原则是,选取与模型复杂度相匹配的硬件。设备的计算能力可以通过浮点运算能力(FLOPS)来衡量,这是评估设备性能的重要指标。例如,一个复杂的卷积神经网络(CNN)可能需要一个具有较高FLOPS的设备来保证实时处理的需求。

5.2 性能优化:资源管理与调度

在硬件选择完成之后,接下来需要考虑的是如何优化模型以适应硬件。这通常涉及模型压缩技术,如网络剪枝、权重量化和知识蒸馏。这些技术能够减少模型的体积以及计算需求,同时尽可能保持模型的准确性。例如,通过应用8位的整数量化(INT8),模型大小可以被显著减少,并且能够利用硬件加速的优势。

资源管理和调度也是优化的关键。在多任务环境中,我们可能需要考虑实时操作系统(RTOS)来管理不同任务的优先级,确保关键任务的实时性。在资源有限的设备上,这意味着必须精心设计任务调度算法,以避免资源竞争导致的性能瓶颈。

5.3 可视化图表:边缘部署架构图

可视化图表是理解复杂系统的有力工具。在部署架构图中,我们可以展示模型如何在边缘设备上运行,包括输入数据的获取、预处理、模型推理、后处理以及输出结果的传输。例如,一个在无人机上部署的物体检测模型架构图将清晰展示从摄像头获取图像,到模型处理,再到发送控制信号的整个流程。

5.4 注释:边缘部署脚本示例

在边缘设备上部署深度学习模型通常需要自动化脚本来完成。以下是一个示例脚本,它使用TensorFlow Lite在Raspberry Pi上部署一个模型:

// 导入TensorFlow Lite运行时

import org.tensorflow.lite.Interpreter;

// 加载模型和标签文件

ByteBuffer tfliteModel = loadModelFile(activity, "model.tflite");

List<String> labels = loadLabels(activity, "labels.txt");

// 初始化TensorFlow Lite解释器

Interpreter.Options options = new Interpreter.Options();

options.setNumThreads(NUM_THREADS);

Interpreter tflite = new Interpreter(tfliteModel, options);

// 加载输入数据

ByteBuffer inputData = loadImage(activity, "image.jpg");

// 执行模型推理

tflite.run(inputData, outputData);

// 解析和使用输出数据

float[] probabilities = (float[]) outputData.get("probability");

int labelIndex = getMaxProbabilityIndex(probabilities);

String label = labels.get(labelIndex);

这段代码首先加载了一个TensorFlow Lite模型和标签文件,然后使用多线程初始化了解释器。接着,它加载了一个输入图像,并将其传递给解释器以得到概率结果。最后,它解析输出数据,找到最高概率的索引,并获取对应的标签。

部署深度学习模型到边缘设备是一个复杂而多面的过程,涉及硬件选择、性能优化和资源管理。这一过程的重点是在保持模型精度的同时最大限度地压缩模型尺寸和计算需求,确保实时性和能效。通过合理的硬件选择和精心设计的优化策略,深度学习模型可以高效地运行在各种边缘设备上,为用户提供即时的智能服务。

6 模型监控与维护

在深度学习模型的部署周期中,模型的监控与维护是确保模型长期稳定运行的关键步骤。这一阶段的工作主要包括对模型性能的持续监控,及时发现并修复模型的潜在问题,以及在数据分布或环境变化时更新模型以保持其精确度。

6.1 指标监控:关键性能指标(KPIs)

对于深度学习模型而言,我们关注如准确性(Accuracy)、精确度(Precision)、召回率(Recall)和F1分数(F1 Score)等指标的实时监控。这些指标反映了模型对新数据的预测能力,是衡量模型性能的关键。例如,对于一个图像分类任务,我们可以使用准确性指标来衡量模型对新图像分类的正确率。我们可以将这些指标的计算公式用数学符号表示出来:

-

准确性(Accuracy):

A c c u r a c y = T P + T N T P + T N + F P + F N Accuracy = \frac{TP + TN}{TP + TN + FP + FN} Accuracy=TP+TN+FP+FNTP+TN

其中,TP、TN、FP、FN分别表示真正例、真负例、假正例和假负例的数量。 -

精确度(Precision):

P r e c i s i o n = T P T P + F P Precision = \frac{TP}{TP + FP} Precision=TP+FPTP -

召回率(Recall):

R e c a l l = T P T P + F N Recall = \frac{TP}{TP + FN} Recall=TP+FNTP -

F1分数(F1 Score):

F 1 = 2 × P r e c i s i o n × R e c a l l P r e c i s i o n + R e c a l l F1 = 2 \times \frac{Precision \times Recall}{Precision + Recall} F1=2×Precision+RecallPrecision×Recall

通过对这些KPIs的实时监控,我们可以及时发现模型性能下降的问题,并进行相应的调整。

6.2 版本控制:模型迭代管理

在模型的生命周期中,我们经常需要对模型进行更新和迭代。这要求我们对模型版本进行严格的控制,以便于追踪模型的变化,并在必要时回滚到之前的版本。版本控制可以通过版本控制系统如Git进行,或是使用专门的模型管理工具如MLflow。

一个好的实践是使用语义化版本控制(Semantic Versioning),对发生变更的模型赋予新版本号。例如,当我们对模型结构做出重大更改时,可以增加主版本号;当我们对模型进行小的改进或优化时,可以增加次版本号;而当只是修复了一些小错误时,可以增加修订号。

6.3 可视化图表:监控系统架构图

一个高效的监控系统通常包括数据收集、性能评估、警报系统和数据可视化等部分。我们可以使用如Grafana或Prometheus这样的工具来构建一个可视化的监控仪表板,实时展示模型的关键性能指标。这些仪表板可以帮助我们快速了解模型的运行状态,并在问题发生时即时响应。

6.4 注释:监控系统代码示例

监控系统的实现需要涉及多个部分。以一个基于Prometheus和Grafana的监控系统为例,我们首先需要定义Prometheus的监控规则,这通常是一个配置文件,其中包括了监控指标的定义和数据抓取的配置。然后,我们可以在Grafana中创建仪表板,并将其连接到Prometheus的数据源,以实时显示这些指标。下面是一个简单的Prometheus配置文件示例:

# prometheus.yml

global:

scrape_interval: 15s

scrape_configs:

- job_name: 'model_monitoring'

static_configs:

- targets: ['<model_serving_endpoint>:<port>']

在这个配置文件中,scrape_interval定义了Prometheus抓取指标的频率,model_monitoring的job_name定义了一个监控任务,其中targets需要替换为模型服务的实际地址和端口。

通过这样的监控系统,我们可以确保对深度学习模型的性能有清晰的了解,并做出及时的调整和优化,保持模型在生产环境中的最佳状态。

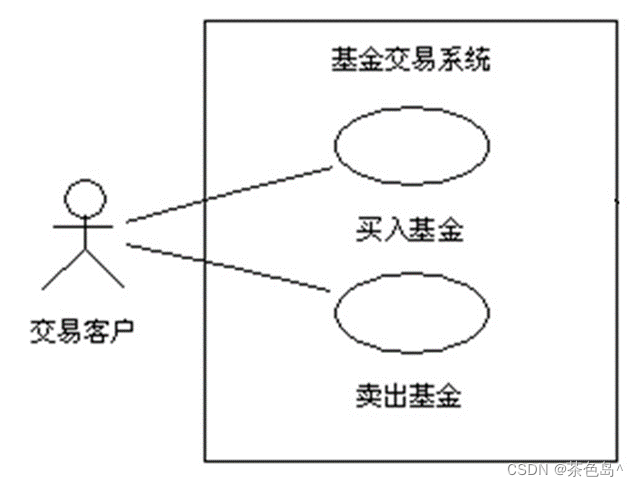

7 用户接口集成

在深度学习项目的生命周期中,用户接口集成是实现模型服务化,直接与用户交互的重要环节。本节将详细探讨如何设计高效、用户友好的API,前端集成技巧,以及通过可视化图表增强用户体验。

7.1 API设计:提供模型服务的接口

API(应用程序编程接口)是软件系统不同部分之间沟通的桥梁,对于深度学习模型而言,良好的API设计使得模型能够以服务的形式被应用程序调用。设计API时,应遵循RESTful原则,即Representational State Transfer,这意味着API应简洁且有自解释性。

- 路径设计:路径应直观,例如,

/predict用于发送预测请求,/update用于模型更新。 - 请求方法:GET方法用于获取资源,POST用于创建资源或提交数据进行处理。

- 数据格式:请求和响应的数据格式应为JSON,因其轻量且易于人类阅读。

例如,一个图像识别模型的API可能接受二进制图像文件,并返回识别结果:

POST /predict

Content-Type: application/json

{

"image": "base64_encoded_image_data"

}

RESPONSE:

Content-Type: application/json

{

"predictions": [

{"label": "cat", "confidence": 0.95},

{"label": "dog", "confidence": 0.05}

]

}

7.2 前端集成:与用户直接交互

前端界面是用户与模型交互的直接窗口。对于非技术用户而言,直观、易用的前端界面至关重要。使用现代前端框架如React或Vue可以快速构建响应式UI。

- 用户输入:根据模型需求设计输入界面,例如,上传图片按钮、文本输入框等。

- 调用API:前端通过AJAX或Fetch API与后端API交互,发送用户输入并接收模型预测结果。

- 结果展示:以图表、文字或其他直观形式展示模型预测结果,提高用户理解度。

举个例子,对于一个文本情感分析模型,前端界面包含文本输入框和提交按钮。用户输入文本后,前端调用后端API进行分析,并将结果以柱状图形式展示。

7.3 可视化图表:用户交互流程图

在用户界面中,使用可视化图表能有效增强数据的理解性。D3.js是一个强大的JavaScript库,支持复杂的数据可视化需求。例如,深度学习模型的预测结果可以通过柱状图、饼图等形式展示,而模型的内部结构和运作流程可以通过流程图和网络图呈现。

- 预测结果可视化:根据预测结果的类型选择合适的图表。例如,分类任务适合使用饼图或条形图,回归任务适合使用折线图。

- 模型解释性可视化:对于复杂模型的预测结果,使用模型解释工具(如LIME或SHAP)并通过可视化解释模型的决策过程。

7.4 注释:API与前端集成代码示例

以下是一个简单的API端点和前端调用示例,用于提供基于深度学习的图像识别服务:

后端API(Python Flask示例)

from flask import Flask, request, jsonify

from model import predict_image # 假设这是预测函数

app = Flask(__name__)

@app.route('/predict', methods=['POST'])

def predict():

if 'image' not in request.files:

return jsonify({'error': 'missing file'}), 400

image = request.files['image']

predictions = predict_image(image)

return jsonify(predictions)

if __name__ == '__main__':

app.run(debug=True)

前端调用(JavaScript Fetch API)

document.getElementById('submit').addEventListener('click', function() {

var image = document.getElementById('image').files[0];

var formData = new FormData();

formData.append('image', image);

fetch('/predict', {

method: 'POST',

body: formData

}).then(response => response.json()).then(data => {

console.log(data);

// 在此处使用数据更新UI

}).catch(error => console.error('Error:', error));

});

通过整合API和前端技术,我们能够为用户提供直接、高效和友好的模型服务体验。深度学习模型的价值在于其应用,而优秀的用户接口集成是实现这一目标的关键步骤。

8 案例分析:部署的故事和教训

8.1 成功案例:行业内的成功部署经历

在深度学习项目的生命周期中,模型部署是实现业务价值的决定性一步。从理论转化为实践,再从实践中提炼出成功的经验,对于未来的项目至关重要。本节将深入分析行业内的一个成功的深度学习模型部署案例,探讨其背后的技术选择、策略实施,以及从中得到的教训。

在这个案例中,我们将重点讨论一个电子商务公司如何成功部署了一个商品推荐系统。该系统基于复杂的协同过滤算法,并结合了用户的历史购买数据和游览记录来预测用户可能感兴趣的新产品。

模型与算法

推荐系统的核心是基于矩阵分解的协同过滤算法,它可以描述为:

r ^ u i = μ + b u + b i + q i T p u \hat{r}_{ui} = \mu + b_u + b_i + q_i^Tp_u r^ui=μ+bu+bi+qiTpu

其中, r ^ u i \hat{r}_{ui} r^ui 表示用户 u u u 对商品 i i i 的预测评分, μ \mu μ 是所有评分的平均值, b u b_u bu 和 b i b_i bi 分别是用户和商品的偏差项,而 q i q_i qi 和 p u p_u pu 是商品和用户的特征向量。

这个模型在一个非常大的数据集上进行了训练,包含数百万的用户评分。为了处理这个规模的数据,采用了随机梯度下降(SGD)算法来优化损失函数:

min q ∗ , p ∗ ∑ ( u , i , r ) ∈ D ( r − r ^ u i ) 2 + λ ( ∥ q i ∥ 2 + ∥ p u ∥ 2 ) \min_{q*, p*} \sum_{(u, i, r) \in D} (r - \hat{r}_{ui})^2 + \lambda(\|q_i\|^2 + \|p_u\|^2) q∗,p∗min(u,i,r)∈D∑(r−r^ui)2+λ(∥qi∥2+∥pu∥2)

在这个优化问题中, D D D 是所有已知评分的集合, r r r 是实际评分,而 λ \lambda λ 是正则化参数,用于防止过拟合。

部署策略

部署这个推荐系统时,公司采用了微服务架构,将推荐引擎作为一个独立的服务来运行。该服务被部署在Kubernetes集群上,利用其自动扩展的功能来应对访问量的波动。

此外,为了实现低延迟的响应,推荐系统的模型被部署在了与数据库相同的地理位置。这样可以减少数据传输的时间,快速地为用户提供推荐结果。

技术成果与教训

这个推荐系统的成功部署显著提高了用户的购买转化率,具体来说,系统的上线使得相关商品的点击率提高了30%,并且购买率提高了15%。这个案例展示了如何将复杂的深度学习模型成功地整合到生产环境中,为公司带来了明显的商业价值。

从中学到的关键教训包括:

- 模型简化与优化:原始的推荐算法需要大量计算资源,通过模型简化和优化,如参数量化和剪枝,能够减少模型的大小和提高推理速度。

- 弹性架构:使用Kubernetes这样的容器编排工具可以帮助模型按需扩展资源,以应对不同的负载需求。

- 数据本地化:构建推荐系统时,使模型服务靠近数据源可以减少延迟,提高用户体验。

- 持续监控与迭代:部署后对模型进行持续的监控和定期的迭代更新,是维持系统长期稳定运行的关键。

通过这个案例,我们可以看到,成功的模型部署不仅需要先进的算法和强大的计算资源,还需要精心设计的架构和持续的维护。这是将深度学习模型从研究室带入实际应用的艺术和科学。

8.2 失败案例:部署过程中的常见陷阱

在深度学习模型部署的领域,成功故事往往广为人知,而失败案例则常常默默无闻,被蒙上一层神秘的面纱。然而,正是这些失败案例,为我们提供了宝贵的学习机会,让我们在未来的部署道路上少走弯路。本节将深入探讨在部署深度学习模型过程中的常见陷阱,并且尝试从中汲取教训。

我们首先来讨论一个经典的案例,该案例中的团队尝试将一个用于图像识别的卷积神经网络(CNN)部署到一个在线图片分类服务中。他们在实验室中的测试结果是令人印象深刻的,模型在多个数据集上都达到了超过95%的准确率。但是,在实际部署后,却发现模型的表现远远低于预期。

1. 数据偏差和数据漂移:

部署后的初期,模型遭遇了现实世界数据分布与训练数据分布不匹配的问题,即所谓的“数据偏差”。模型是在高度标准化的数据集上进行训练的,而现实世界的输入数据却充满噪点和变异。举例来说,模型未能正确处理在复杂背景下拍摄的图片,因为训练数据大多是在简单背景前的图片。

进一步的问题在于“数据漂移”,即随着时间推移,输入数据的分布发生了变化。例如,季节的变化可能会影响用户上传图片的内容和风格。

2. 硬件和软件兼容性问题:

在迁移到生产环境时,团队没有考虑到实际部署环境和开发环境之间的差异。这包括处理器的差异,比如从支持AVX-512指令集的CPU迁移到不支持该指令集的CPU,导致模型性能大幅下降。

3. 资源限制和成本问题:

另一个问题是没有正确估计运行模型所需的资源,包括计算资源、存储和带宽。模型部署后,高并发请求导致延迟变高,成本也随之升高。

4. 模型的易用性和维护性:

模型被设计得过于复杂,难以维护。其中一个典型的错误是没有将模型切片成小模块,导致任何小的改动都需要重新部署整个模型。

5. 安全性和隐私:

忽视了模型安全性,使得模型容易受到对抗性攻击。例如,攻击者可以通过向模型输入精心设计的图片,使得模型输出错误的分类结果。

现在,让我们更深入地探索这些问题背后的数学和技术概念:

数据偏差可以使用下面的公式来量化:

δ = D train ( X ) − D deploy ( X ) \delta = D_{\text{train}}(X) - D_{\text{deploy}}(X) δ=Dtrain(X)−Ddeploy(X)

其中, D train ( X ) D_{\text{train}}(X) Dtrain(X) 是训练数据的分布, D deploy ( X ) D_{\text{deploy}}(X) Ddeploy(X) 是部署后数据的分布, δ \delta δ 是分布之间的差异。

对于数据漂移,我们可以定义一个时间相关的分布差异度量:

Δ ( t ) = D deploy , t 0 ( X ) − D deploy , t ( X ) \Delta(t) = D_{\text{deploy}, t_0}(X) - D_{\text{deploy}, t}(X) Δ(t)=Ddeploy,t0(X)−Ddeploy,t(X)

在 t 0 t_0 t0时刻部署后的数据分布和 t t t时刻的数据分布之间的差异被表示为 Δ ( t ) \Delta(t) Δ(t)。

在处理硬件和软件兼容性问题时,可以使用如下的性能指标函数来评估不同硬件上的模型性能:

P ( h , s ) = 1 N ∑ i = 1 N f ( m i , h , s ) P(h, s) = \frac{1}{N} \sum_{i=1}^{N} f(m_i, h, s) P(h,s)=N1i=1∑Nf(mi,h,s)

其中, P P P 是性能指标, h h h 代表硬件, s s s 代表软件环境, m i m_i mi 是模型实例, N N N 是模型实例的数量, f f f 是一个函数,用来计算给定硬件和软件环境下的模型性能。

在资源限制和成本问题中,成本可以表示为:

C = α × C compute + β × C storage + γ × C network C = \alpha \times C_{\text{compute}} + \beta \times C_{\text{storage}} + \gamma \times C_{\text{network}} C=α×Ccompute+β×Cstorage+γ×Cnetwork

C C C 是总成本, C compute C_{\text{compute}} Ccompute、 C storage C_{\text{storage}} Cstorage 和 C network C_{\text{network}} Cnetwork 分别是计算、存储和网络的成本。 α \alpha α、 β \beta β 和 γ \gamma γ 是这些资源在整体成本中所占比例的权重。

在解决模型的易用性和维护性问题时,模块化可以使用信息隐藏的概念来量化,每个模块都提供一个接口和隐藏其内部细节的实现:

I ( M ) = ∑ i = 1 k ∣ H i ∣ ∑ i = 1 k ∣ T i ∣ I(M) = \frac{\sum_{i=1}^{k} |H_i|}{\sum_{i=1}^{k} |T_i|} I(M)=∑i=1k∣Ti∣∑i=1k∣Hi∣

I ( M ) I(M) I(M) 是模块化程度的指标, ∣ H i ∣ |H_i| ∣Hi∣ 是模块 i i i 的隐藏信息量, ∣ T i ∣ |T_i| ∣Ti∣ 是模块 i i i 的总信息量, k k k 是模块的数量。

最后,在考虑模型的安全性和隐私问题时,可以通过计算模型对对抗样本的敏感性来评估其鲁棒性:

R ( m , A ) = 1 ∣ S ∣ ∑ x ∈ S I ( m ( x ) ≠ m ( A ( x ) ) ) R(m, A) = \frac{1}{|S|} \sum_{x \in S} \mathbb{I}(m(x) \neq m(A(x))) R(m,A)=∣S∣1x∈S∑I(m(x)=m(A(x)))

R ( m , A ) R(m, A) R(m,A) 是模型 m m m 对抗样本生成算法 A A A 的鲁棒性, S S S 是样本集合, I \mathbb{I} I 是指示函数。

从这些公式中可以看出,成功的模型部署需要对一系列复杂的因素进行考量,从数据处理到硬件选择,再到资源管理和安全性保护。每个因素都需要精心设计和预测,以避免部署过程中的陷阱。

让我们从这些失败案例中学习,并确保我们的部署策略能够充分考虑到这些复杂多变的因素,以确保模型在生产环境中的顺利运行。在下一节中,我们将通过可视化图表进一步分析案例比较。

8.3 可视化图表:案例对比分析

在深度学习项目的部署阶段,可视化图表是理解和沟通模型性能的关键。通过将成功和失败的案例进行对比分析,我们可以更直观地识别成功的因素和失败的教训。我们通常通过多个维度来展示这些对比,包括但不限于:模型准确度、响应时间、资源使用效率和用户满意度。

以准确度和响应时间为例,我们可以通过散点图来表示不同模型的这两个指标。在这个2D空间中,理想的模型会靠近右上角,显示出高准确度和低响应时间。让我们来细致地展开分析:

KaTeX parse error: Unexpected end of input in a macro argument, expected '}' at end of input: …xt{-轴表示准确度(%)}

点的大小可以表示模型大小或资源消耗量,颜色深浅可以表示用户满意度(从深色表示高满意度到浅色表示低满意度)。这样的可视化不但提供了丰富的信息,还可以帮助我们一目了然地辨识哪些模型在实际部署中表现最佳。

考虑到可视化的复杂性,我们还可以使用混淆矩阵(Confusion Matrix)来评估模型的性能。混淆矩阵是一个非常强大的工具,它展示了模型预测的真实类别与预测类别之间的关系:

混淆矩阵 = [ TP FP FN TN ] \text{混淆矩阵} = \begin{bmatrix} \text{TP} & \text{FP} \\ \text{FN} & \text{TN} \end{bmatrix} 混淆矩阵=[TPFNFPTN]

其中:

- TP(True Positives):正确的正类预测数量

- FP(False Positives):错误的正类预测数量

- FN(False Negatives):错过的正类预测数量

- TN(True Negatives):正确的负类预测数量

通过混淆矩阵,我们可以计算出诸如准确度、精确度、召回率和F1分数等关键指标。例如,准确度的计算公式为:

准确度(Accuracy) = T P + T N T P + F P + F N + T N \text{准确度(Accuracy)} = \frac{TP + TN}{TP + FP + FN + TN} 准确度(Accuracy)=TP+FP+FN+TNTP+TN

精确度(Precision)和召回率(Recall)分别反映了模型针对正类的预测准确性和覆盖率:

精确度(Precision) = T P T P + F P 召回率(Recall) = T P T P + F N \text{精确度(Precision)} = \frac{TP}{TP + FP} \\ \text{召回率(Recall)} = \frac{TP}{TP + FN} 精确度(Precision)=TP+FPTP召回率(Recall)=TP+FNTP

而F1分数则是精确度和召回率的调和平均数,是两者的综合指标:

F1分数 = 2 × Precision × Recall Precision + Recall \text{F1分数} = 2 \times \frac{\text{Precision} \times \text{Recall}}{\text{Precision} + \text{Recall}} F1分数=2×Precision+RecallPrecision×Recall

这些指标不仅可以用于评估单一模型,还可以在案例对比分析中发挥作用。比如,我们可以通过柱状图来显示不同案例的F1分数,从而直观地对比哪些模型在平衡精确度与召回率方面做得更好。

在实际案例中,例如在医疗影像识别的部署案例,我们可以看到拥有较高F1分数的模型往往得到了临床医生的青睐,因为这意味着模型在减少漏诊(FN)和误诊(FP)方面表现良好。另一方面,自然语言处理(NLP)系统的部署案例则更加重视响应时间,这是因为用户交云服务期望获得即时反馈。

综上所述,通过对部署案例中的关键性能指标进行可视化对比分析,我们不仅能够识别出哪些模型部署成功,还能从失败中汲取教训,为未来的项目提供宝贵的参考。

8.4 注释:案例分析中的关键代码片段

在这一部分,我们将深入探讨几个关键的代码片段,这些代码是模型部署过程中不可或缺的。我们将分析每一个代码片段的作用,并解释它们在整个部署过程中扮演的角色。我们也会详细探讨这些代码背后的数学原理和逻辑。

模型压缩代码示例

在部署深度学习模型之前,模型压缩是一个关键步骤。这可以帮助减少模型的体积和提高运行效率。以下是一个模型压缩的代码示例,其中使用了权重剪枝技术:

// 模型压缩 - 权重剪枝

public void pruneWeights(NeuralNetwork network, double threshold) {

for (Layer layer : network.getLayers()) {

for (Neuron neuron : layer.getNeurons()) {

for (Synapse synapse : neuron.getOutgoingSynapses()) {

// 将绝对值小于阈值的权重设置为零

if (Math.abs(synapse.getWeight()) < threshold) {

synapse.setWeight(0);

}

}

}

}

}

这段代码通过遍历神经网络中的每一层,进而遍历每个神经元,最终检查每个突触的权重。如果权重的绝对值小于预设的阈值threshold,这个权重将被置为零。这种方法可以减少模型的大小,因为那些权重为零的连接可以在存储和传输时被忽略。

w i j ′ = { 0 , if ∣ w i j ∣ < t h r e s h o l d w i j , otherwise w'_{ij} = \begin{cases} 0, & \text{if $|w_{ij}| < threshold$} \\ w_{ij}, & \text{otherwise} \end{cases} wij′={0,wij,if ∣wij∣<thresholdotherwise

其中 ( w_{ij} ) 是原始权重,( w’_{ij} ) 是剪枝后的权重。

模型优化代码示例

为了在边缘设备上实现更好的性能,模型通常需要针对特定硬件进行优化。以下是一个使用TensorFlow Lite进行模型优化的代码片段:

// 将TensorFlow模型转换为TensorFlow Lite格式

public void convertToTFLite(String savedModelDir, String tfliteModelDir) {

// 使用TFLiteConverter对模型进行转换和优化

TFLiteConverter converter = TFLiteConverter.fromSavedModel(savedModelDir);

converter.setOptimize(Optimize.DEFAULT);

// 设置量化参数以减小模型大小并提高运行速度

converter.setTargetSpec(new TargetSpec.Builder().setSupportedOps(EnumSet.of(SupportedOp.FLOAT16, SupportedOp.INT8)).build());

// 保存转换后的模型

byte[] tfliteModel = converter.convert();

Files.write(Paths.get(tfliteModelDir), tfliteModel);

}

这个函数将一个TensorFlow模型转换为TensorFlow Lite模型。转换过程中,它设置了模型的优化参数,并指定了目标硬件的支持指令集,比如浮点16位和整型8位运算,以达到模型压缩和加速的目的。

模型部署监控代码示例

在模型部署之后,监控模型的性能是至关重要的。以下是一个简单的监控系统的代码片段,用于记录模型的预测时间:

// 记录模型预测时间

public void logPredictionTime(NeuralNetwork network, DataInstance instance) {

long startTime = System.nanoTime();

network.predict(instance);

long endTime = System.nanoTime();

// 计算并记录预测时间

long predictionTime = endTime - startTime;

System.out.println("Prediction time: " + predictionTime + " nanoseconds");

}

这个函数通过测量神经网络预测一个数据实例所需的时间,来监控模型的性能。系统纳秒时间戳用于计算开始和结束时间之间的差值,这个差值即为预测时间。通过对这个时间的持续监控,我们可以了解模型在实际环境中的表现。

通过这些深入的技术解释和代码示例,我们希望能够提供一个关于深度学习模型部署过程中的关键考虑因素的全面视角。每个案例都充分展示了在将深度学习模型从原型变为生产级应用时所需的技术和策略。通过这些案例,我们可以学习到如何优化模型架构、减少计算资源需求以及提高模型效率和可扩展性。

9 安全性与合规性

在当今深度学习模型日益融入日常应用的背景下,安全性与合规性问题成为了我们不可忽视的重要议题。本章节将深入讨论如何确保部署的模型能够在保护用户隐私的同时,遵守严格的法律法规。

9.1 数据安全:确保用户数据保密性

数据安全的核心在于保证数据的保密性、完整性及可用性。其中,保密性指确保数据仅对授权用户可见。例如,使用深度学习模型处理敏感个人信息时,我们可能会采用对称加密算法如AES(Advanced Encryption Standard),其数学表达为:

C = E k ( P ) C = E_k(P) C=Ek(P)

P = D k ( C ) P = D_k(C) P=Dk(C)

其中,(C)是密文,(P)是明文,(E)表示加密过程,(D)表示解密过程,而(k)是双方约定的密钥。

在实际部署中,可能会引入安全套接层(SSL)证书,为数据传输提供加密通道,避免中间人攻击。同时,为了防止数据在内存中被窃取,会采用基于硬件的安全技术,如Intel的SGX(Software Guard Extensions)来建立可信的执行环境(TEE, Trusted Execution Environment)。

9.2 法律合规:遵守数据保护法规

随着GDPR(General Data Protection Regulation)和CCPA(California Consumer Privacy Act)等数据保护法规的实施,对数据处理和存储的要求更加严格。合规性不仅要求企业保护用户数据,还要求他们必须在数据处理过程中保持透明,并赋予用户对自己数据的控制权。例如,GDPR规定了数据主体权利,包括访问权、更正权、删除权等。

在这种法律框架下,模型的部署需要遵循“隐私设计”的原则。即在设计模型和部署架构时,就要考虑数据保护的要求。技术实践中,可能会采用的一个方法是差分隐私(Differential Privacy),其核心思想是在数据集中添加一定程度的随机噪声,从而使得模型输出对单个数据点不敏感。差分隐私的数学表达可以通过以下公式概括:

P r [ K ( D ) ∈ S ] ≤ e ϵ × P r [ K ( D ′ ) ∈ S ] + δ Pr[\mathcal{K}(D) \in S] \leq e^\epsilon \times Pr[\mathcal{K}(D') \in S] + \delta Pr[K(D)∈S]≤eϵ×Pr[K(D′)∈S]+δ

这里,(D)和(D’)是邻近的数据集,(S)是可能的输出集合,(\mathcal{K})是随机算法,(\epsilon)是隐私损失,而(\delta)是概率的偏差上限。

9.3 可视化图表:安全合规流程图

一个清晰的安全合规流程图可以帮助理解整个复杂系统中的数据流和控制点。例如,一个典型的流程图可能包括数据的收集、加密存储、访问控制审核、数据处理和输出结果的加密传输等环节。每一个环节都需要设计严密的安全控制措施。

9.4 注释:安全性最佳实践代码示例

在部署深度学习模型时,实现安全性最佳实践可能涉及到代码层面的多个方面,例如:

// 使用HTTPS加密API接口,避免数据在传输过程中被窃取

public SecureRestTemplate getRestTemplate() {

return new SecureRestTemplate();

}

// 使用基于角色的访问控制来限制数据接口的权限

public ResponseEntity<String> getUserData(@PathVariable String userId,

@AuthenticationPrincipal User user) {

if (user.canAccessUserData(userId)) {

// 处理数据请求

} else {

// 返回无权限的响应

}

// ...

}

安全性与合规性是深度学习模型部署的重要组成部分,对于企业来说,投资在这方面的资源是保护品牌信誉和合法权益的关键。通过合理设计数据加密、访问控制和法律合规的工作流程,我们能够在享受深度学习带来的便利的同时,确保数据的安全和用户的隐私。

10 性能优化与自动扩展

在今天的互联网环境中,深度学习模型的部署不仅仅是关于模型本身的优化,也涉及到如何在生产环境中高效、稳定地服务于终端用户。这就引出了两个关键概念:性能优化与自动扩展。接下来,让我们深入探讨这两个方面,并通过具体的实例和数学公式来阐述它们的重要性和实现方式。

10.1 负载均衡:应对访问量波动

负载均衡是分散到多个执行单元的技术,用于提高网站、应用程序和数据库的可用性和性能。在深度学习模型的部署中,负载均衡能够确保模型服务平稳运行,即使在请求量激增的情况下也不会崩溃。负载均衡的关键在于,它可以动态地将入站请求分配到最少负载的服务器上。

例如,假设有一个深度学习模型服务,其背后有 n n n个服务器可用。每次请求到来时,负载均衡器会选择一个最佳服务器来处理该请求。数学上,可以将此过程视为优化问题:

选择服务器 i = a r g m i n i 负载 ( S i ) \text{选择服务器} \ i \ = \ \underset{i}{\mathrm{argmin}} \ \text{负载}(S_i) 选择服务器 i = iargmin 负载(Si)

其中, 负载 ( S i ) \text{负载}(S_i) 负载(Si)表示第 i i i个服务器当前的负载程度。选择负载最小的服务器可以最大化请求的处理效率,减少用户等待时间。

10.2 自动扩展:资源按需分配

自动扩展是云计算服务的一部分,允许系统根据预定义的规则和指标自动增加或减少资源。在深度学习模型的部署中,这意味着系统可以根据实际负载情况动态地调整计算资源,从而保持高效的服务水平。

假设模型服务的目标是保持平均响应时间小于100毫秒。如果监测到持续时间超过此阈值,自动扩展系统可以启动更多的实例来分散负载。相反,如果负载降低,系统可以自动减少实例数量以节省成本。数学上,自动扩展策略可以表示为:

如果 X ˉ > T 则增加实例 , \text{如果} \ \bar{X} > T \ \text{则增加实例}, 如果 Xˉ>T 则增加实例,

如果 X ˉ < T 则减少实例 , \text{如果} \ \bar{X} < T \ \text{则减少实例}, 如果 Xˉ<T 则减少实例,

其中, X ˉ \bar{X} Xˉ是当前的平均响应时间, T T T是设定的阈值。

10.3 可视化图表:性能优化机制图

为了直观地理解性能优化和自动扩展的工作原理,我们可以通过可视化的方式展示系统如何响应不同的负载情况。这可以通过时间序列图表来展示,其中x轴表示时间,y轴表示系统负载或响应时间。通过这种方式,可以清楚地看到系统何时触发了扩展或缩减资源的操作。

10.4 注释:自动扩展策略代码示例

为了实现自动扩展策略,通常需要依赖云服务提供商的API或专有服务。以下是一个简化的伪代码,展示了如何根据负载自动调整资源数量的基本逻辑:

// 伪代码:基于负载的自动扩展策略

if (平均响应时间 > 设定的阈值) {

// 增加实例

增加云服务实例(数量);

} else if (平均响应时间 < 设定的阈值 && 当前实例数 > 最小实例数) {

// 减少实例

减少云服务实例(数量);

}

在实际部署中,需要结合具体的云平台(如AWS、Google Cloud或Azure)提供的工具和API来实现这一逻辑。

通过深入探讨性能优化与自动扩展的概念、原理和实践方法,我们可以确保深度学习模型在生产环境中的高效、稳定运行。这不仅提升了用户体验,还为企业节省了大量的资源和成本。

11 进阶:模型服务化与商业模式

在深入探讨如何将深度学习模型商业化之前,我们首先需要理解模型服务化的含义。模型即服务(Model-as-a-Service, Maas)是一种新兴的商业模式,它允许用户通过云基础设施访问和使用深度学习模型。这种服务化不仅可以减少用户的前期投资,还能使得模型的更新和维护更加高效。

11.1 模型即服务:SaaS模式在AI中的应用

在SaaS(Software-as-a-Service)模式中,软件和应用程序被托管在云端,用户可以通过订阅的方式访问它们。类似地,Maas允许开发者将训练好的模型部署到云端服务器,用户则通过API调用这些模型来进行预测,而无需关心模型的维护和升级问题。

例如,假设我们有一个图像识别模型,可以通过以下公式表示模型的预测函数:

f ( x ; θ ) = σ ( W x + b ) f(x; \theta) = \sigma(Wx + b) f(x;θ)=σ(Wx+b)

其中,( x ) 是输入图像的特征向量, ( θ = { W , b } ) ( \theta = \{W, b\} ) (θ={W,b}) 是模型参数, ( σ ) ( \sigma ) (σ) 是激活函数,比如ReLU或Sigmoid。用户通过发送HTTP请求,将图像数据传输到服务端,即可接收到预测结果。

11.2 商业模型:如何盈利

在AI领域,盈利模式可以多种多样。一种常见的方式是按次计费,即用户每调用一次模型服务就支付一定的费用。另一种方式是订阅制,用户支付定期的费用以获得一定数量的API调用额度。

例如,对于一个NLP(自然语言处理)服务,它可能提供情感分析、翻译、摘要等功能,每项功能都对应一个特定的API端点。如情感分析功能的预测函数可能是:

P ( Positive ∣ x ) = 1 1 + e − ( W x + b ) P(\text{Positive}|x) = \frac{1}{1+e^{-(Wx+b)}} P(Positive∣x)=1+e−(Wx+b)1

用户需要对每个端点进行调用以实现所需的服务,并相应地产生费用。

11.3 可视化图表:商业模型流程图

商业模型的流程图可以帮助用户快速理解服务的结构。例如,一个流程图可能包括用户注册、API密钥生成、API调用、计费和反馈等步骤。

11.4 注释:构建SaaS平台的代码架构

构建一个SaaS平台通常涉及以下几个关键的技术组件:

- API网关:管理用户的请求和认证,提供安全的入口。

- 负载均衡器:确保请求均匀分配到各个服务实例,以便高效处理。

- 服务容器:宿主运行模型的服务,例如使用Docker容器。

- 数据库:存储用户数据和使用记录,例如使用MySQL或MongoDB。

- 计费系统:跟踪API调用次数并生成账单,可能需要整合第三方支付服务。

具体的代码架构会涉及到各种技术的选择和架构设计的细节,但在此不展开以免超出篇幅。总体来说,构建这样一个平台需要跨学科的知识和团队合作。

通过上述的概述和细节解释,我们可以看到深度学习模型服务化并不是一个简单的过程。它涉及到多方面的知识,如模型优化、云服务管理、API设计、商业模式创新等。这些都需要我们作为开发者去不断学习和实践,以便能够在这个快速发展的领域中找到属于自己的位置。

12 结语

在探索深度学习模型部署的旅程中,我们已经涵盖了从基础的模型压缩和转换技术,到选择合适的部署环境,再到具体的云端和边缘部署策略,以及维护和性能优化的各个方面。我们还分析了模型服务化和商业化的路径。现在,在本篇文章的结尾,是时候对这些内容进行汇总,展望未来,并鼓励读者将这些最佳实践应用于自己的工作中。

汇总:模型部署的最佳实践总结

模型部署的过程是复杂而细致的,涉及了众多步骤和决策点。最佳实践建议包括:

- 模型压缩和转换:通过技术如权重剪枝、量化和知识蒸馏,我们可以减少模型体积和提升运行效率。例如,模型量化可以将32位的浮点数转换为较小的位数表示,公式如下:

W ′ = quantize ( W ) = r o u n d ( W S ) W' = \text{quantize}(W) = round(\frac{W}{S}) W′=quantize(W)=round(SW)

其中,(W) 代表原始权重,(W’) 是量化后的权重,(S) 是缩放因子。

-

部署环境的选择:根据应用的需求,选择合适的部署环境,是在云端还是边缘设备上,都有各自的优缺点。云服务能提供强大的计算资源,而边缘计算能减少延迟,提高响应速度。

-

持续维护:监控关键性能指标(KPIs)确保模型性能,同时利用版本控制进行模型迭代管理。例如,使用滑动窗口法计算模型精度的变化:

Accuracy t = 1 N ∑ i = 0 N − 1 1 ( y i = f ( x i ; θ t ) ) \text{Accuracy}_{t} = \frac{1}{N}\sum_{i=0}^{N-1} \mathbb{1}(y_i = f(x_i; \theta_t)) Accuracyt=N1i=0∑N−11(yi=f(xi;θt))

其中, ( 1 ) ( \mathbb{1} ) (1) 是指示函数, ( θ t ) ( \theta_t ) (θt) 是在时间 ( t ) 的模型参数,( N ) 是窗口大小。

- API和用户界面:通过RESTful API设计和前端集成,提供模型服务的接口,让用户能够轻松地与模型交互。

未来视角:部署趋势及未来技术

我们期待着自动化部署和优化技术的发展,它们会大大简化深度学习模型进入生产环境的过程。未来的趋势可能包括:

- 自适应部署:模型能够根据运行环境自动调整自身配置。

- 联邦学习:模型在不同设备上共享学习经验而不共享数据本身,以此提高隐私保护。

- 神经网络架构搜索(NAS):自动发现高效的模型架构,适应特定的部署环境。

鼓励实践:推广模型部署的重要性

将深度学习模型部署到生产环境是一个挑战,但它提供了实现人工智能在日常生活中应用的机会。我们鼓励研究者和工程师练习和完善这些技能,将模型从理论转化为实际应用,为社会带来创新和价值。

我们希望上述的实践和未来趋势能够为读者在深度学习领域的部署工作带来启发,并激励大家继续在这一令人兴奋的领域中探索和创新。不断进步的技术和不断演化的最佳实践,将引领我们实现智能化的未来。

![C++ 性能分析的实战指南(gperftools工具)[建议收藏]](https://img-blog.csdnimg.cn/direct/bed87ab1fcf646bb8bebe0d18c928190.png)